Die tägliche Herausforderung im 1st-Level-Support eines Systemhauses

Die manuelle Suche nach Lösungen in verschiedenen Datenquellen ist zeitaufwendig und ineffizient. Jeder Mitarbeiter muss sich durch eine Vielzahl von Dokumenten und Einträgen arbeiten, um die richtige Lösung zu finden. Dies führt zu längeren Wartezeiten, frustrierten Kunden und überlasteten Mitarbeitern. Zudem fehlt es häufig an einer zentralisierten Wissensdatenbank, die alle relevanten Informationen schnell und einfach zugänglich macht, was die Situation gerade für neue Mitarbeiter unübersichtlich macht.

Identifikation der Anforderungen und Datenquellen

In einem initialen Workshop ermitteln wir die spezifischen Anforderungen des 1st-Level-Supports. Wir analysieren bestehende Prozesse, Datenquellen und Systeme, um Antworten auf folgende Fragen zu erhalten: Welche Arten von Support-Anfragen werden am häufigsten bearbeitet? Welche Datenquellen nutzen die Mitarbeiter zur Problemlösung? Wie sind die Daten stukturiert? Gemeinsam mit dem Systemhaus erstellen wir eine Skizze, wie die individuelle KI-Lösung den Support am besten entlasten kann.

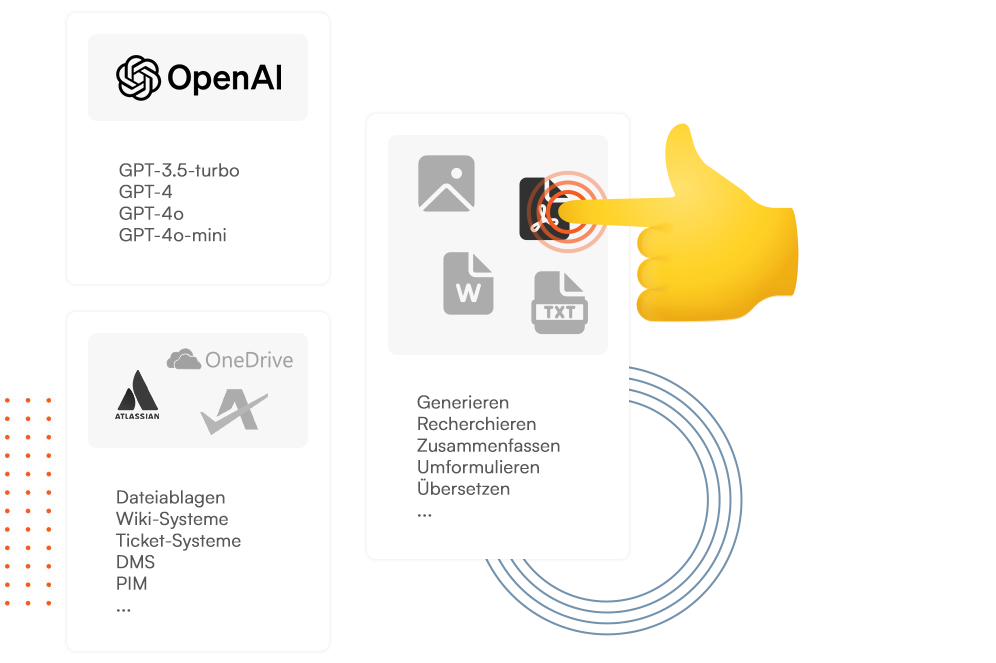

Datenaufbereitung und generative KI

Basierend auf den Erkenntnissen aus dem Workshop wählen wir die am besten geeignete Technologie und das passende KI-Modell für die bestehenden Anforderungen aus. Die Daten liegen in unterschiedlichen Quellen vor, darunter Netzlaufwerke, Wiki-Systeme und Ticket-Systeme, und müssen darüberhinaus unterschiedlich aufbereitet werden: je nach dem, ob es sich um Anleitungen, Dokumentationen oder historische Tickets handelt. Wir erstellen für jede Datenquelle passgenaue Schnittstellen und bereiten die Daten strukturiert und kontextbezogen auf, um sie bestmöglich KI-lesbar zu machen. Für die Generierung der Anleitung zur Lösung der Support-Anfrage wird ein geeignetes Large Language Modell ausgewählt. Wir wählen ein Modell, dass konsistent qualitativ gute Ergebnisse in kurzer Zeit liefert. Aufgrund des täglich hohen Ticket-Aufkommens sind auch die Kosten des Modells ein wichtiges Kriterium.

Erste Ergebnisse

Auf Basis der ausgewählten Technologien erstellen wir den ersten voll funktionsfähigen Prototypen. Hierfür kombinieren wir klassische Software-Entwicklung wie Schnittstellenprogrammierung mit generativer künstlicher Intelligenz. So entsteht im ersten Schritt ein Eingabefenster, in das Support-Mitarbeiter Ticketnummern eingeben. Das LLM gibt als Antwort mögliche Lösungen für das im Ticket beschriebene Problem aus. Unseren Prototypen trainieren wir anhand des im Workshop erstellten Testsets um spezifische Antworten hervorzubringen und die Support-Mitarbeiter bestmöglich zu unterstützen.

Praxistest unter realen Bedingungen

Im Praxistest wird der Prototyp von ausgewählten echten Nutzern ausgiebig geprüft. Im Sekundentakt werden die neuen Tickets automatisch an MILE AI übergeben und dort aufbereitet. Mit jeder Support-Anfrage lernt die MILE AI Anwendung dazu und verarbeitet die neu gewonnen Informationen bereits für die Beantwortung des nächsten Support-Tickets. Gemeinsam mit den ersten Nutzern legen wir fest, wie viele Lösungsvorschläge die KI präsentieren soll und in welcher Detailtiefe um eine bestmögliche Entlastung bei der täglichen Arbeit zu schaffen.

Feinschliff und Integration

Auf Basis des Feedbacks aus der Validierungsphase verbessern wir die Qualität und Detailtiefe der Antworten unserer KI-Lösung. Ausgangspunkt dafür ist die Erstellung des optimalen Systemprompts über mehrere Iterationen hinweg. Beispielsweise ergänzen wir die Ausgabe der Lösungsvorschläge noch um Besonderheiten, die in der Vergangenheit bei den Support-Anfragen vermehrt auftraten.

In dieser Phase findet auch die Integration in die Bestandssysteme statt, so dass die KI-generierten Lösungsvorschläge für die in den Tickets genannten Probleme direkt am Ticket angezeigt werden und keine manuelle Eingabe der Ticketnummer mehr erforderlich ist. Dadurch wird die Ticketbearbeitung weiter vereinfacht und beschleunigt.

Hohe Akzeptanz der Lösung

Aufgrund der tiefen Integration in die Bestandssysteme erfolgt die Nutzung unserer KI-Anwendung durch die Support-Mitarbeiter auf täglicher Basis quasi „nebenbei“ als Addon. Die Support-Mitarbeiter müssen sich nicht mit einem neuen System auseinandersetzen, sondern erhalten die genau auf ihre Bedürfnisse zugeschnittenen KI-Anleitungen in gewohnter Umgebung. Das erhöht gleichzeitig die Akzeptanz bei den Mitarbeitern und hält den Schulungsbedarf gering. Durch die Feedback-Funktion erhalten wir permanent Rückmeldung zur Qualität der Antworten von MILE AI und bleiben mit den Mitarbeitern im konstruktiven Austausch für einen konitnuierlichen Verbesserungsprozess.

Die Echtzeitanbindung an das Ticketsystem und die hohe Qualität der zur Verfügung gestellten Lösungsvorschläge reduziert sich die Bearbeitungszeit der Tickets erheblich.

Verbesserung der Mitarbeiter- und Kunden-Zufriedenheit

Der Einsatz von MILE AI im 1st Level-Support unterstützt die Support-Mitarbeiter dabei konsistentere und präzisere Lösungen für Support-Anfragen zu finden. Gleichzeitig reduziert sich die Bearbeitungszeit pro Ticket, da langwierige Recherchen entfallen. Das macht nicht nur die Mitarbeiter, sondern auch die Kunden zufriedener: Mitarbeiter werden von repetitiven Aufgaben entlastet und die Service-Qualität gegenüber den Kunden verbessert sich. Auch bei erhöhtem Ticketaufkommen können die Mitarbeiter einen kühlen Kopf bewahren und auf Basis der von MILE AI zur Verfügung gestellten Lösungsvorschläge die bestmögliche Lösung für den Kunden finden.

Maßgeschneidert!

Wir entwickeln passgenaue KI-Lösungen!

Sprechen Sie mit uns kostenlos und unverbindlich über Ihren spezifischen Anwendungsfall für künstliche Intelligenz in Ihrem Unternehmen. Erfahren Sie, wie wir eine maßgeschneidert Lösung für Ihre spezifischen Use-Cases entwickeln.